- Trang chủ

-

/ Giao dịch định lượng có từ bao giờ nhỉ?

Giao dịch định lượng có từ bao giờ nhỉ?

21/05/2025

828 lượt đọc

Trong hơn một thế kỷ, giao dịch định lượng đã lặng lẽ chuyển mình từ một ý niệm thuần túy học thuật, khi Louis Bachelier lần đầu dùng toán xác suất mô tả giá chứng khoán năm 1900, thành bộ máy vận hành cốt lõi của thị trường tài chính hiện đại, nơi mỗi quyết định mua bán được thúc đẩy bởi mô hình xác suất, kho dữ liệu khổng lồ và hạ tầng công nghệ có độ trễ tính bằng micro-giây.

1. Khởi nguồn từ sự âm thầm, một luận án bị lãng quên (1900)

Tháng 3 năm 1900, tại Đại học Sorbonne, Louis Bachelier bảo vệ luận án “La Théorie de la Spéculation”. Ông dùng khái niệm chuyển động Brown để mô tả biến động giá trái phiếu quốc gia Pháp – điều chưa từng có trong kinh tế học thời đó. Hội đồng chấm luận án chấm mức “đủ đạt”, vì “toán học quá trừu tượng, ít giá trị thực dụng”. Sau buổi bảo vệ, bản thảo xếp lại trong thư viện, gần như không trích dẫn suốt nửa thế kỷ.

Điều ít ai ngờ: khung xác suất mà Bachelier đưa ra – giá tài sản là một tiến trình ngẫu nhiên có phương sai tỷ lệ với thời gian – về sau trở thành nền tảng cho mọi mô hình định giá phái sinh. Chính điểm khởi nguồn “âm thầm” đó cho thấy đặc trưng của giao dịch định lượng: tưởng là lý thuyết khô khan, nhưng khi thị trường đủ lớn, khối lượng đủ dày, toán học sẽ phát huy sức mạnh.

2. Kỷ nguyên hậu chiến, toán học bước vào Phố Wall (1950–1970)

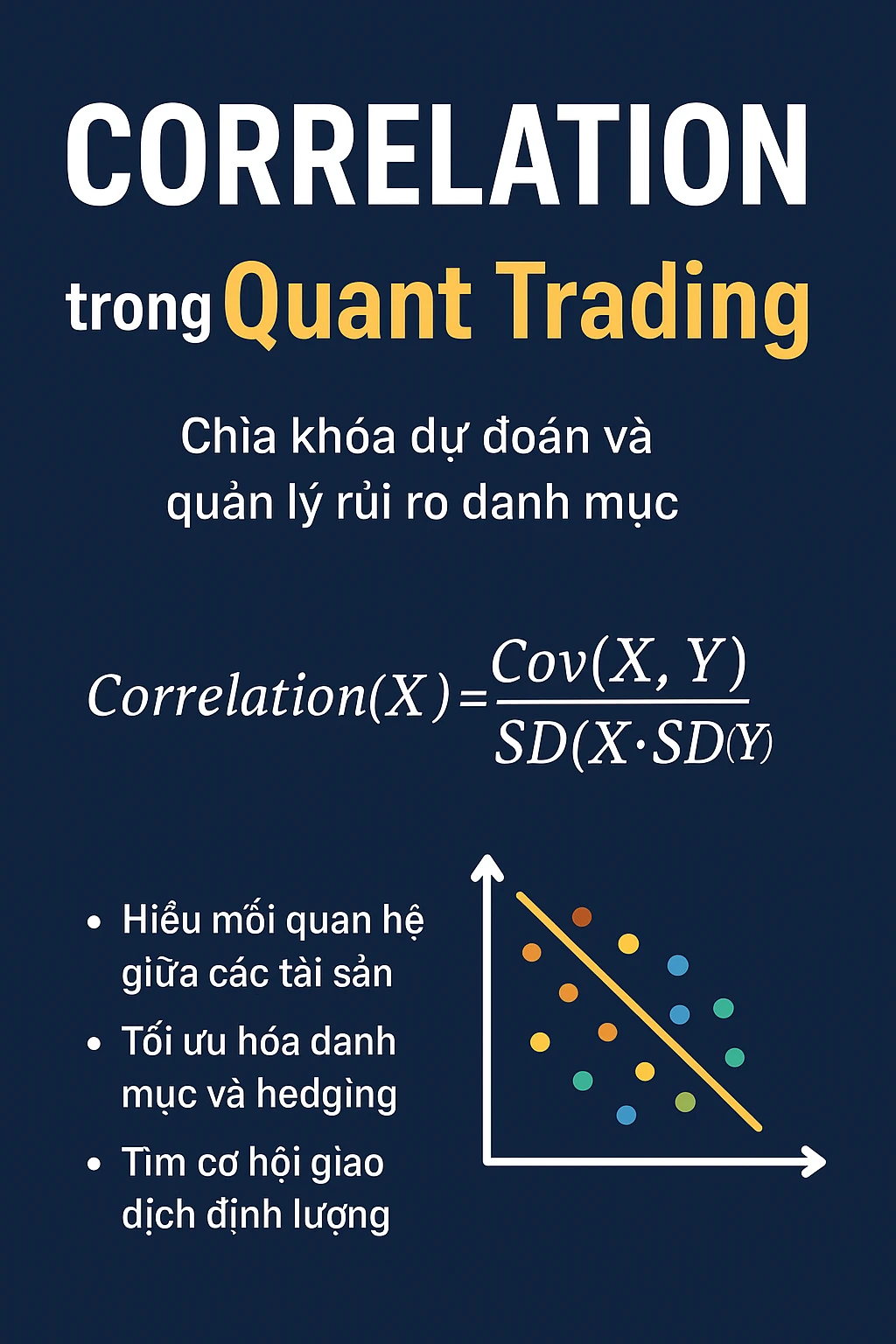

Sau Thế chiến II, Mỹ nổi lên thành siêu cường công nghiệp; Phố Wall đối mặt khối vốn khổng lồ đổ về, nhu cầu đa dạng hóa rủi ro tăng vọt. Harry Markowitz công bố Modern Portfolio Theory (1952): không chọn cổ phiếu “ngon” nhất, mà tối ưu toàn bộ danh mục trên trục lợi nhuận–rủi ro. Bài báo ban đầu được coi là “thuần học thuật”, nhưng khi quỹ tương hỗ bắt đầu công bố thành tích kém ổn định, các CIO buộc phải tìm cách đo lường hệ số tương quan, ước lượng phương sai.

Đầu thập niên 60, Benjamin Graham – “cha đẻ trường phái value” – thuê sinh viên trẻ Edwin Thorp làm trợ lý quỹ phòng hộ Graham–Newman. Thorp áp dụng xác suất để tối ưu chiến lược đặt cược trong sòng bài trước khi chuyển mô hình sang thị trường quyền chọn không niêm yết. Cuốn “Beat the Dealer” bán chạy năm 1962 khiến cộng đồng tài chính chú ý: nếu toán học đánh bại nhà cái, tại sao không đánh bại thị trường?

Song song ở Harvard, William Sharpe phát triển CAPM (1964) lượng hóa mối liên hệ giữa rủi ro hệ thống và lợi nhuận kỳ vọng bằng hệ số beta. Từ đây, phòng giao dịch tuyển tiến sĩ thống kê, kinh tế lượng để tính beta danh mục, chạy hồi quy trên mainframe IBM 7090 – mở màn cho vai trò “quant analyst”.

3. Công thức Black-Scholes và cú hích máy tính (1970–1985)

Ngày 26 tháng 4 năm 1973, Sàn giao dịch quyền chọn Chicago (CBOE) khai trương với 16.000 hợp đồng tại 911 Marquette Building. Trên cùng ngày, tạp chí Journal of Political Economy đăng bài “The Pricing of Options and Corporate Liabilities” của Fischer Black & Myron Scholes. Công thức định giá quyền chọn châu Âu ngay lập tức trở thành “chuẩn mực vàng” vì cung cấp mức giá lý thuyết thay vì mặc cả thủ công.

Khi Black-Scholes chấp nhận biến động (sigma) là tham số đầu vào, bài toán chuyển thành “ngược”: từ giá thị trường → suy ngược sigma nội hàm (implied volatility). CBOE lập tức niêm yết chuỗi IV đầu tiên; trader hiểu rằng mua – bán option giờ không chỉ dựa “cảm tính” mà so với bề mặt biến động (vol surface).

Cùng kỳ, NYSE triển khai hệ thống DOT (Designated Order Turnaround) rồi SuperDOT, cho phép công ty môi giới gửi lệnh điện tử. Thời gian khớp giảm từ vài phút xuống dưới 30 giây – một vũ khí chiến lược vì Black-Scholes yêu cầu delta hedging liên tục. Phần mềm OptionVue (1983) chạy trên DOS cho phép cập nhật vol, delta, gamma theo thời gian thực – lần đầu tiên ghi nhận giao dịch định lượng “quay vòng” theo cấp phút.

Sự kết hợp giữa mô hình chuẩn + cơ sở hạ tầng khớp điện tử khiến định lượng bước khỏi giảng đường, bám rễ vào bàn giao dịch.

4. Program Trading, Arbitrage Thống kê và cú sụp 1987

Cuối thập niên 80, tư duy program trading – mua hoặc bán rổ cổ phiếu dựa trên chênh lệch chỉ số tương lai (index futures) – được ưa chuộng. Morgan Stanley và Goldman Sachs triển khai thuật toán “portfolio insurance” tái cân bằng delta danh mục so với kỳ vọng thị trường, bán mạnh khi giá giảm.

Ngày 19 tháng 10 năm 1987, Dow Jones mất 508 điểm, tương đương 22,6 %, cú rơi tệ nhất lịch sử. Nghiên cứu sau này chỉ ra một phần nguyên nhân đến từ program trading bán tháo dây chuyền. Dù hậu quả nặng nề, sự kiện Black Monday buộc nhà đầu tư nghiêm túc đánh giá rủi ro thuật toán – mở ra ngành quản trị rủi ro định lượng (quant risk) cùng khái niệm Value-at-Risk (JP Morgan giới thiệu năm 1994).

Cũng giai đoạn này, các giáo sư Chicago – như Gene Fama – phát triển Arbitrage Pricing Theory, còn nhóm sửa đổi box-Jenkins hoàn thiện kiểm định Augmented Dickey-Fuller. Hedge Fund tương đối trẻ LTCM (Long-Term Capital Management) áp dụng hàm cointegration, pairs trading trái phiếu kho bạc Mỹ – cho lợi nhuận 40 %/năm ba năm liên tiếp, trước khi sụp đổ năm 1998 do đòn bẩy 30:1 và khủng hoảng Nga.

Bài học LTCM khẳng định: mô hình có thể đúng 99 %, nhưng cú sốc 1 % đủ thổi bay nếu quản trị rủi ro sai. Giới quant chuyển trọng tâm từ “tìm mô hình tốt nhất” sang “xây khung kiểm soát tail-risk”.

5. Internet, Big Data, High-Frequency Trading (2000–2015)

Internet băng rộng đưa dữ liệu tick và order book đến bàn giao dịch trong mili-giây. Thuật toán ICEBERG, Sniper, Pegged ra đời để ẩn lệnh, phát hiện thanh khoản. Thương vụ lớn nhất lúc bấy giờ: ICE mua lại ECN Archipelago (2006), biến New York Stock Exchange thành sàn điện tử hoàn toàn.

Song song, các công ty như Getco, Jump Trading, Hudson River xây dựng đường cáp quang riêng Chicago ↔ New York, cắt latency xuống 8 ms; sau này, Microwave giảm còn 4 ms. High-Frequency Trading (HFT) khai thác chênh lệch giá vài cent, vòng quay hàng chục nghìn lần/ngày. Năm 2010, HFT chiếm 60–70 % khối lượng giao dịch cổ phiếu Mỹ.

Flash Crash 6 / 5 / 2010 – Dow Jones rơi 1000 điểm trong 36 phút – cho thấy mặt trái của tốc độ: thuật toán phản hồi với chuỗi lệnh giả, thanh khoản cạn sạch. Sau sự kiện, CFTC/SEC ban hành quy tắc “circuit breaker” 5 %, yêu cầu thử nghiệm kill-switch, đồng thời thông qua Reg SCI buộc sàn duy trì hạ tầng công nghệ an toàn.

6. Thập niên dữ liệu thay thế và AI (2015-đến nay)

Khi giá và khối lượng không còn là lợi thế độc quyền, cuộc đua chuyển sang alternative data: ảnh vệ tinh đếm xe bãi đỗ Walmart, tín dụng thẻ ghi tiêu dùng, cảm xúc mạng xã hội. Quỹ Two Sigma duy trì 800 nguồn dữ liệu phi truyền thống; Point72 Analytics có riêng nhóm NLP trích sentiment từ báo cáo thu nhập doanh nghiệp.

Học sâu (deep learning) bước vào trading: mạng LSTM dự báo chuỗi thời gian, Transformer xếp hạng ảnh hưởng vĩ mô, reinforcement learning tối ưu vị thế về rủi ro. Sau đại dịch, khái niệm MLOps (machine-learning operations) lan sang desk trading: pipeline dữ liệu, feature store, dịch vụ suy diễn (inference) chạy 24/7 song song với hệ thống OMS/EMS.

Ở tầm xa, quantum computing hứa hẹn giải bài toán tối ưu danh mục đa tài sản với ràng buộc phi tuyến gấp nghìn lần nhanh hơn – nếu qubit vượt mốc 1.000. Dù còn trong phòng thí nghiệm, Goldman, JP Morgan, CaixaBank đã ký hợp tác với IBM Quantum nhằm sẵn sàng cho “thế hệ siêu máy tính” mới.

7. Đâu là năng lực cốt lõi của một quant hiện đại?

- Tư duy xác suất – thống kê: hiểu dữ liệu và sai số mẫu.

- Kỹ năng lập trình: Python, C++, SQL, Spark; triển khai trên cloud, low-latency C++.

- Kiến trúc hệ thống: thu thập, lưu trữ, streaming, backtest, risk sandbox, OMS/EMS.

- Quản trị rủi ro: từ VaR, Expected Shortfall đến stress-testing, scenario analysis.

- Kỷ luật thực thi: mô hình đúng – hạ tầng ổn định – giám sát con người.

Kết luận

Giao dịch định lượng không phải là “cỗ máy in tiền” mà là hành trình dài gom góp lý thuyết toán, sức mạnh máy tính và kỷ luật vận hành, liên tục thích nghi với dữ liệu mới và rủi ro mới.

Từ bài luận của Bachelier tới đường cáp quang HFT, điểm chung duy nhất là khát khao đo lường sự bất định rồi biến nó thành lợi thế. Ai nắm được dữ liệu tốt hơn, mô hình hoá sâu hơn và quản trị rủi ro kỷ luật hơn, người đó có lợi thế dài hạn.

Hãy xây dựng và kiểm thử chiến lược giao dịch phái sinh của bạn trên nền tảng QMTRADE trước khi sử dụng tiền thật để tránh những rủi ro không đáng có.

.webp)

Đánh giá

0 / 5